언스플래쉬 제공

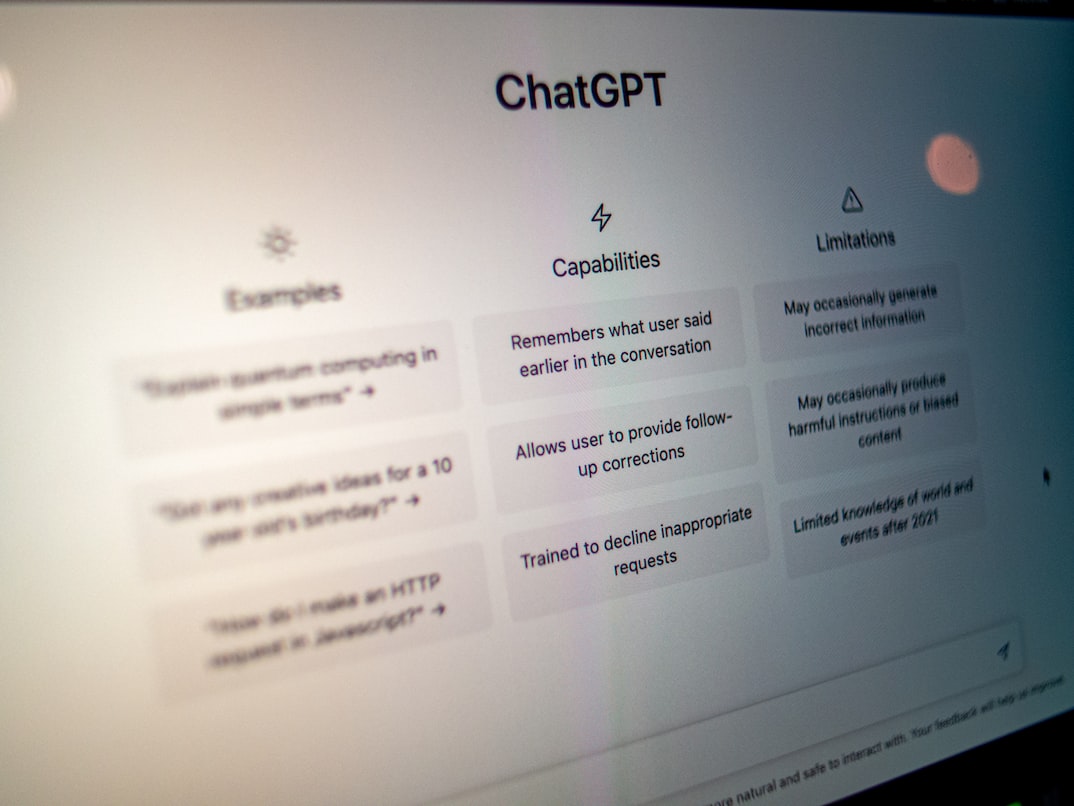

챗GPT에 대한 관심이 뜨거워지면서 챗GPT가 인생의 고민에 대해서도 답변을 내놓기를 기대하는 이들이 많다. 그렇지만 도덕적 딜레마를 갖고 있는 문제에 대해 질문을 하고 답을 듣는 것은 위험을 초래할 수 있다는 연구 결과가 나왔다.

언스플래쉬 제공

언스플래쉬 제공

생성 AI에 대한 열풍은 챗GPT 이전부터 예견됐습니다. 지난해 8월 미국 콜로라도 주립박람회 미술대회에서 제이슨 앨런이 ‘미드저니’라는 생성 AI를 이용해 출품한 ‘스페이스 오페라 극장’이라는 작품이 디지털아트 분야 1등을 차지하면서 수상 여부에 대한 논란이 불붙었을 때 이미 시작됐다고 볼 수 있습니다. 최근 대형 서점을 들러 봤다면 챗GPT 관련 책이 너무 많아 깜짝 놀랐을 것입니다. 챗GPT를 이용해 쓴 챗GPT 책들까지 나오고 있습니다. 이런 책 중에는 인생의 고민을 챗GPT를 통해 물어보고 그 답을 정리한 것들까지 있습니다. 그런데 챗GPT의 답이 사람의 생각에 영향을 미칠 수 있다면 어떻게 하시겠습니까.

제이슨 앨런이 ‘미드저니’라는 생성AI를 이용해 만든 ‘스페이스 오페라 극장’. 이 작품은 지난해 한 미술대회에서 1등을 차지하면서 인공지능이 만든 그림에 상을 줘야 하는지에 대해 논란이 일었다.

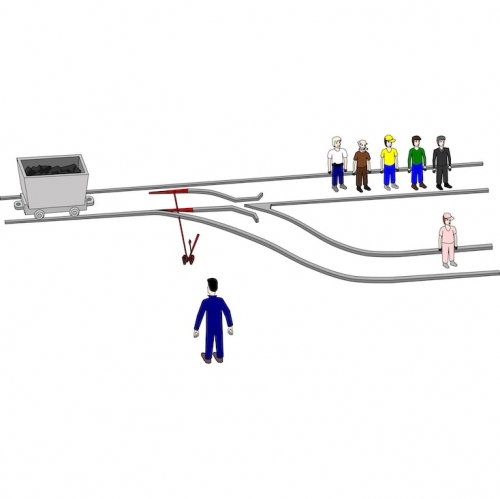

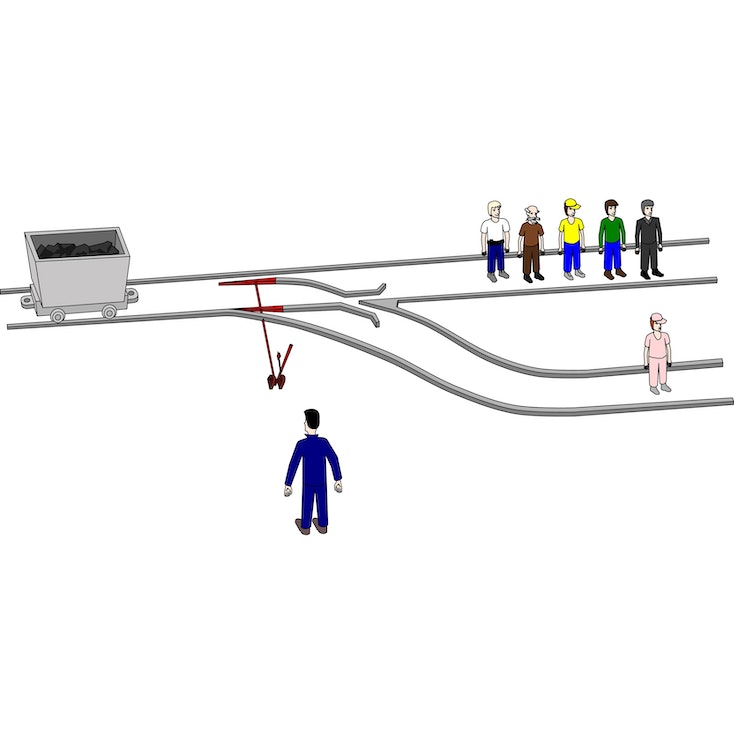

연구팀은 ‘트롤리 딜레마’를 다양한 방식으로 변형시킨 질문을 던져 챗GPT가 답변하도록 했습니다. 트롤리 딜레마는 정치철학자인 마이클 샌델 미국 하버드대 교수가 쓴 책 ‘정의란 무엇인가’의 첫 부분에 나오는 유명한 사고실험입니다. 브레이크가 고장 난 트롤리 전차가 시속 100㎞로 달리고 있는 상황에서 궤도 앞쪽에 5명의 인부가 작업을 하는데, 그들은 귀마개를 끼고 있어 전차가 오는 소리를 듣지 못합니다. 당신은 트롤리 전차의 선로를 바꿀 수 있는 레버 앞에 서 있습니다. 문제는 바뀌는 선로에도 1명의 작업자가 있다는 것입니다. 과연 어떤 선택을 해야 할까요. 5명의 인부는 나와 상관없는 사람이고 1명은 가족이나 친지라면 처음 선택과 달라질까요.

브레이크가 고장난 트롤리 열차가 달려오는 상황에서 5명을 다치게 할 것인가, 선로를 바꿔 1명을 다치게 할 것인가. 만약 그 1명이 가족이라면 어떻게 할 것인가. 철학, 윤리학 분야에서 자주 언급되는 ‘트롤리 문제’

실험 참가자의 80% 이상이 자신은 챗GPT가 내놓은 답에 영향을 받지 않았다고 응답했지만 실제 그들의 판단과 주장은 챗GPT가 제시한 것과 거의 일치하는 것으로 나타났다고 합니다. 인공지능에 영향을 받지 않는다고 주장은 하지만 실제로는 사람들이 도덕적 판단을 내릴 때 챗GPT 같은 AI가 내놓는 답에 상당한 영향을 받을 수 있다는 것을 의미한다고 연구팀은 설명했습니다.

제바스티안 크뤼겔 독일 잉골슈타트 응용과학대 박사는 “AI 학습 과정에서 도덕적 판단이 필요한 질문에 대한 답변은 거부하거나 다양한 논거와 주의사항까지 답해 주는 인공지능 챗봇을 설계하는 것이 필요하다”고 강조했습니다.

Copyright ⓒ 서울신문. All rights reserved. 무단 전재-재배포, AI 학습 및 활용 금지